مقدمة في أخلاقيات الذكاء الاصطناعي | الوحدة الثالثة | الدرس الأول

مقدمة في أخلاقيات الذكاء الاصطناعي هو عنوان الدرس الأول من الوحدة السادسة التي تحمل اسم “الذكاء الاصطناعي والمجتمع” من مقرر “الذكاء الاصطناعي” الفصل الدراسي الثاني.

ستتعرف في هذا الموضوع على أخلاقيات الذكاء الاصطناعي (AI Ethics)، وتحديد المخاوف الأخلاقية في مجال الذكاء الاصطناعي، والعوامل التي تحدِّد تحيُّز أنظمة الذكاء الاصطناعي للحد منها، وغيرهم من المصطلحات الهامة.

لذا قم بقراءة أهداف التعلُّم بعناية، ثم أعد قراءتها وتأكَّد من تحصيل محتواها بعد انتهائك من دراسة الموضوع.

أهداف التعلُّم

- معرفة ماهية أخلاقيات الذكاء الاصطناعي.

- تحديد المخاوف الأخلاقية في مجال الذكاء الاصطناعي.

- تحديد العوامل التي ترجِّح تحيُّز أنظمة الذكاء الاصطناعي.

- استعراض مشكلة المسؤولية الأخلاقية في الذكاء الاصطناعي.

- فهم الشفافية وقابلية التفسير في الذكاء الاصطناعي ومشكلة الصندوق الأسود.

- تمثيل الاستدلال القائم على القيم في أنظمة الذكاء الاصطناعي.

- معرفة تأثير الذكاء الاصطناعي على البيئة.

- معرفة الأُطر التنظيمية ومعايير صناعة أنظمة الذكاء الاصطناعي.

- معرفة الإرشادات العالمية لأخلاقيات الذكاء الاصطناعي.

هيا لنبدأ!

نظرة عامة على أخلاقيات الذكاء الاصطناعي (Overview of AI Ethics)

مع استمرار تقدُّم الذكاء الاصطناعي تزايدت أهمية التفكير في الآثار الأخلاقية المترتبة على استخدام هذه التقنية، ومن المهم أن يفهم المواطن في عَالَمنا الحديث الدور الهام لأخلاقيات الذكاء الاصطناعي إذا أردنا تطوير أنظمة ذكاء اصطناعي مسؤولة واستخدامها.

أخلاقيات الذكاء الاصطناعي (AI Ethics)

تشير أخلاقيات الذكاء الاصطناعي إلى المبادئ، والقيم، والمعايير الأخلاقية التي تنظِّم تطوير أنظمة الذكاء الاصطناعي وانتشارها واستخدامها.

إن أحد الأسباب الرئيسة للتأكيد على أهمية أخلاقيات الذكاء الاصطناعي هو التأثير الكبير لأنظمة الذكاء الاصطناعي على حياة الإنسان.

على سبيل المثال، يمكِن استخدام خوارزميات الذكاء الاصطناعي لاتّخاذ قرارات التوظيف والعلاج الطبي، وإذا كانت هذه الخوارزميات متحيِّزة أو تمييزية، فقد تؤدي إلى نتائج غير عادلة تضر بالأفراد والمجتمعات.

لمزيد من المعلومات عن أخلاقيات الذكاء الاصطناعي، قم بالاطّلاع على الرابط التالي:

أمثلة من العَالَم الواقعي على المخاوف الأخلاقية في مجال الذكاء الاصطناعي (Real-World Examples of Ethics Concerns in AI)

- الخوارزمية التمييزية

هناك مواقف تدل على أن أنظمة الذكاء الاصطناعي تميل إلى التحيُّز والتمييز ضد فئات معيَّنة من البشر.

على سبيل المثال، وجدت دراسة أجراها المعهد الوطني للمعايير والتقنية (National Institute of Standards and Technology) أن نِسب الخطأ في تقنية التعرُّف على الوجه تكون أعلى عند التعرُّف على وجوه الأشخاص ذوي البشرة الداكنة؛ مما قد يؤدي إلى تحديد هويات خاطئة واعتقالات خاطئة.

ومن الأمثلة الأخرى على ذلك استخدام خوارزميات الذكاء الاصطناعي في نظام العدالة الجنائية، إذ أظهرت الدراسات أن هذه الخوارزميات يمكِن أن تكون متحيِّزة ضد الأقليات؛ مما يؤدي إلى عقوبات أقسى.

- انتهاك الخصُوصية

يمكِن أن تكون أنظمة الذكاء الاصطناعي التي تجمع البيانات وتحلِّلها مصدر تهديد للخصوصية الشخصية.

على سبيل المثال، جمعت شركة استشارات سياسية في عام 2018 م بيانات الملايين من مستخدِمي فيسبوك (Facebook) دون موافقتهم واستخدمتها للتأثير على الحملات السياسية، وأثار هذا الحادث المخاوِف بشأن استخدام الذكاء الاصطناعي وتحليلات البيانات في التلاعب بالرأي العام، وانتهاك حقوق خصوصية الأفراد.

- الأسلحة ذاتية التحكُّم

تطوير الأسلحة ذاتية التحكُّم التي يمكِن أن تعمل دون تدخُّل بشري له مخاوف أخلاقية بشأن استخدام الذكاء الاصطناعي في الحروب، حيث يرى فريق من المنتقدين أن هذه الأسلحة يمكِن أن تتخذ قرارات مصيرية دون إشراف بشري، ويمكِن برمجتها لاستهداف مجموعات معيَّنة من الناس؛ مما قد ينتهك القانون الإنساني الدولي، ويؤدي إلى وقوع إصابات في صفوف المدنيين.

- التسريح من الوظائف

أثار الاستخدام المتزايد للذكاء الاصطناعي والأتمتة (Automation) في مختلف الصناعات المخاوِف بشأن تسريح البشر من وظائفهم وتأثيره على سبل عيش العاملين، فعلى الرغم من أن الذكاء الاصطناعي يمكِنه أن يؤدي إلى تحسين الكفاءة والإنتاجية، إلا أنه يمكِن أن يؤدي أيضًا إلى فقدان البشر لوظائفهم وتزايد عدم المساواة في الدخل؛ مما قد يكون له عواقب اجتماعية واقتصادية سلبية.

مقدمة في أخلاقيات الذكاء الاصطناعي

التحيُّز والإنصاف في الذكاء الاصطناعي (Bias and Fairness in AI)

تحيُّز الذكاء الاصطناعي (AI Bias)

في مجال الذكاء الاصطناعي، يدل التحيُّز على ميل خوارزميات التعلُّم الآلي إلى إنتاج نتائج تحابي بدائل، أو فئات معيَّنة، أو تظلمها بأسلوب منهجي؛ مما يؤدي إلى القيام بتنبؤات خاطئة وإلى احتمالية التمييز ضد منتَجات معيَّنة أو فئات بشرية محدَّدة.

يمكِن أن يظهر التحيُّز (Bias) في أنظمة الذكاء الاصطناعي عندما تكون البيانات المُستخدَمة لتدريب الخوارزمية ناقصة التمثيل أو تحتوي على تحيُّزات أساسية، ويمكِن أن يظهر في أية بيانات تمثِّلها مخرَجات النظام، فعلى سبيل المثال لا الحصر: المُنتَجات والآراء والمجتمعات والاتجاهات كلها يمكِن أن يظهر فيها التحيُّز.

يعدُّ نظام التوظيف الآلي الذي يستخدِم الذكاء الاصطناعي لفحص المرشحين للوظائف من أبرز الأمثلة على الخوارزميَّة المُتحيِّزة.

افترض أن الخوارزميَّة مدرَّبة على بيانات متحيِّزة، مثل أنماط التوظيف التاريخية التي تفضِّل مجموعات ديموغرافية معيَّنة، ففي هذه الحالة قد يعمل الذكاء الاصطناعي على استمرار تلك التحيُّزات ويستبعد المرشَّحين المؤهّلين بشكل غير عادل من بين المجموعات متجاهلًا الفئات غير الممثَّلة جيدًا في مجموعة البيانات.

على سبيل المثال، افترض أن الخوارزمية تفضِّل المرشحين الذين التحقوا بجامعات النخبة، أو عملوا في شركات مرموقة، ففي هذه الحالة قد يلحق ذلك الضرر بالمرشحين الذين لم يحظوا بتلك الفُرص، أو الذين ينتمون إلى بيئات أقل حظًا، ويمكِن أن يؤدي ذلك إلى نفس التنوع في مكان العمل وإلى استمرارية عدم المساواة، ولذلك من المهم تطوير واستخدام خوارزميات توظيف للذكاء الاصطناعي تستنِد على معايير عادلة وشفافة، وغير متحيِّزة.

يشير الإنصاف (Fairness) في الذكاء الاصطناعي إلى كيفية تقديم أنظمة الذكاء الاصطناعي لنتائج غير متحيِّزة وعلى معاملتها لجميع الأفراد والمجموعات معامَلة منصِفة، ولتحقيق الإنصاف في الذكاء الاصطناعي يتطلَّب ذلك تحديد التحيُّزات في البيانات والخوارزميات وعمليات اتّخاذ القرار ومعالجتها.

على سبيل المثال، تتمثَّل إحدى طرائق تحقيق الإنصاف في الذكاء الاصطناعي في استخدام عملية تسمى إلغاء الانحياز (Debiasing)، حيث يتم تحديد البيانات المتحيِّزة وإزالتها أو تعديلها بما يضمن وصول الخوارزميَّة إلى نتائج أكثر دقّة دون تحيُّز.

مقدمة في أخلاقيات الذكاء الاصطناعي

الحدّ من التحيُّز وتعزيز الإنصاف في أنظمة الذكاء الاصطناعي (Reducing Bias and Promoting Fairness in AI Systems)

- البيانات المتنوعة والمُمثَّلة

يقصد بذلك استخدام البيانات التي تعكس تنوع المجموعة التي يتم تمثيلها، كما أنه من المهم مراجعة وتحديث البيانات المُستخدَمة لتدريب أنظمة الذكاء الاصطناعي بانتظام؛ للتأكُّد من أنها ما زالت ملائمة وغير متحيِّزة.

- تقنيات إلغاء الانحياز

تتضمن أساليب إلغاء الانحياز تحديد وإزالة البيانات المُتحيِّزة من أنظمة الذكاء الاصطناعي؛ لتحسين معايير الدّقَّة والإنصاف، فتشمل هذه التقنيات، مثلًا: زيادة العينات (Oversampling)، أو تقليل العينات (Undersampling)، أو زيادة البيانات (Data Augmentation) لضمان تعرُّض نظام الذكاء الاصطناعي لنقاط بيانات مختلفة.

- القابلية للتفسير والشفافية

إن جعل أنظمة الذكاء الاصطناعي أكثر شفافية وأكثر قابلية للتفسير يمكِنه أن يساعد في تقليص مستوى التحيُّز من خلال السماح للمُستخدِمين بفهم كيفية اتّخاذ النظام للقرارات، ويتضمن ذلك توضيح عملية اتّخاذ القرار والسماح للمُستخدِمين باستكشاف مخرَجات النظام واختبارها.

- التصميم المعتمد على إشراك الإنسان

يمكِن أن يساهم إشراك العنصر البشري في حلقة تصميم أنظمة الذكاء الاصطناعي في التقليل من التحيُّز، وذلك بالسماح للبشر بالتدخُّل وتصحيح مخرَجات النظام عند الضرورة، ويشمل ذلك تصميم أنظمة ذكاء اصطناعي بها مرحلة للتغذية الراجعة تمكِّن البشر من مراجعة قرارات النظام والموافقة عليها.

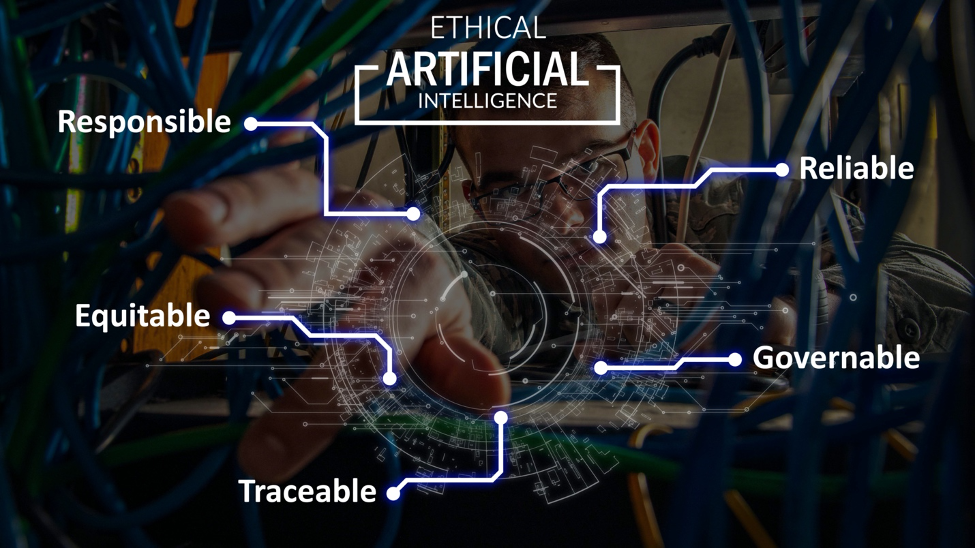

- المبادئ الأخلاقية

تعني دمج المبادئ الأخلاقية، مثل: الإنصاف والشفافية والمساءلة، في تصميم وتنفيذ أنظمة الذكاء الاصطناعي، من أجل ضمان تطوير تلك الأنظمة واستخدامها بشكل أخلاقي ومسؤول، وذلك بوضع إرشادات أخلاقية واضحة لاستخدام أنظمة الذكاء الاصطناعي ومراجعة هذه الإرشادات بانتظام وتحديثها عند الضرورة.

- المراقبة والتقييم بانتظام

تعدُّ المراقبة والتقييم بشكل دوري لأنظمة الذكاء الاصطناعي أمرًا ضروريًا لتحديد التحيُّز وتصحيحه، ويتضمن ذلك اختبار مخرَجات النظام وإجراء عمليات تدقيق منتظمة؛ للتأكُّد من أن النظام يعمل بشكل عادل ودقيق.

- تقييم تغذية المُستخدَم الراجعة

يمكِن أن تساعد التغذية الراجعة التي يقدمها المُستخدِم في تحديد التحيُّز في النظام؛ لأن المُستخدِمين غالبًا ما يكونون أكثر وعيًا بتجاربهم، ويمكِنهم تقديم رؤى عن التحيُّز المحتمل أفضل مما يمكِن أن تقدمه خوارزميات الذكاء الاصطناعي.

على سبيل المثال، يمكِن أن يقدِّم المُستخدِمون تغذية راجعة عن رؤيتهم لأداء نظام الذكاء الاصطناعي أو تقديم اقتراحات مفيدة لتحسين النظام وجعله أقل تحيُّزًا.

مشكلة المسؤولية الأخلاقية في الذكاء الاصطناعي (The Problem of Moral Responsibility in AI)

تعدُّ مشكلة المسؤولية الأخلاقية عند استخدام أنظمة الذكاء الاصطناعي المتقدمة قضية معقَّدة ومتعددة الجوانب، وقد حظيت باهتمام كبير في السنوات الأخيرة.

تتمثَّل إحدى التحديات الرئيسة لأنظمة الذكاء الاصطناعي المتقدمة في قدرتها على اتّخاذ القرارات والقيام بإجراءات يمكِن أن يكون لها عواقب إيجابية أو سلبية كبيرة على الأفراد والمجتمع، ورغم ذلك، لا يكون الطرف الذي يجب تحميله المسؤولية الأخلاقية عن هذه النتائج محدَّدًا دائمًا.

هناك رأي يقول: إن مطوِّري ومصمِّمي أنظمة الذكاء الاصطناعي يجب أن يتحملوا المسؤولية عن أي نتائج سلبية تَنتُج عن استخدامها، ويؤكِّد هذا الرأي على أهمية ضمان تصميم أنظمة ذكاء اصطناعي تراعي الاعتبارات الأخلاقية وتُحمِّل المطوِّرين المسؤولية عن أي ضرر قد تسببه اختراعاتهم.

ويرى آخرون أن المسؤولية عن نتائج الذكاء الاصطناعي هي مسؤولية مشتركة بين أصحاب المصلحة بما فيهم صنّاع السياسات، والمنظمين ومستخدِمي التقنية، ويسلط هذا الرأي الضوء على أهمية ضمان استخدام أنظمة الذكاء الاصطناعي بطرائق تتماشى مع المبادئ الأخلاقية، وتقييم المخاطر المرتبطة باستخدامها وإدارتها بعناية.

وهناك رأي ثالث يقول: إن أنظمة الذكاء الاصطناعي هي “ذاتٌ مسؤولة” لديها حسٌّ أخلاقي ومسؤولة عن أفعالها، وتقول هذه النظرية: إن أنظمة الذكاء الاصطناعي المتقدِّمة يمكِن أن تتمتع بالفاعلية والاستقلالية؛ مما يجعلها أكثر من مجرد أدوات، كما تتطلَّب منها أن تكون مسؤولة عن أفعالها، إلا أن لهذه النظرية عدة مشكلات.

تستطيع أنظمة الذكاء الاصطناعي أن تصدِر أحكامًا وأن تتصرف من تلقاء نفسها، ولكنها ليست “ذاتًا مسؤولة” لديها حسٌّ أخلاقي، وذلك للأسباب التالية:

- أن أنظمة الذكاء الاصطناعي تفتقر إلى الوعي والخبرات الذاتية؛ مما يعدُّ سمة أساسية من سمات “الذات المسؤولة” التي لديها حسٌّ أخلاقي، وفي العادة تتضمن الفاعلية الأخلاقية القدرة على التفكير في المُثُل العليا للفرد وأفعاله.

- يقوم الأشخاص بتدريب أنظمة الذكاء الاصطناعي على اتّباع قواعد وأهداف محدَّدة؛ مما يحدُّ من حكمها الأخلاقي، ويمكِن لأنظمة الذكاء الاصطناعي تكرار اتّخاذ القرارات الأخلاقية، مع افتقارها للإرادة الحُرة والاستقلالية الشخصية.

- إن منشئي أنظمة الذكاء الاصطناعي والقائمين على نشرها هم المسؤولون عن أفعالهم، ويمكِن لأنظمة الذكاء الاصطناعي أن تساعد في اتّخاذ القرارات الأخلاقية، على الرغم من أنها ليست “ذاتًا مسؤولة” لديها حسٌّ أخلاقي.

بإمكانك مراجعة محتوى موضوع “مقدمة في أخلاقيات الذكاء الاصطناعي” من بدايته وحتى نهاية هذا القسم، من خلال الرابط التالي:

الشفافية وقابلية التفسير في الذكاء الاصطناعي ومشكلة الصندوق الأسود (Transparency and Explainability in AI and the Black-Box Problem)

نظام الصندوق الأسود (Black-Box System)

هو نظام لا يكشف عن طرائق عمله الداخلية للبشر؛ إذ تتم التغذية بالمُدخَلات، ليتم إنتاج المُخرَجات دون معرفة طريقة عملها، كما هو موضَّح في الشكل التالي.

تكمن مشكلة الصندوق الأسود في الذكاء الاصطناعي في التحدي المُتمثِّل في فهم كيفية عمل نظام قائم على الذكاء الاصطناعي (AI-Based System) باتّخاذ القرارات أو إنتاج المُخرَجات؛ مما قد يُصعِّب الوثوق بالنظام أو تفسيره أو تحسينه، وربما يؤثر الافتقار إلى الانفتاح وإلى قابلية التفسير على ثقة الناس في النموذج.

تتزايد هذه التحديات بوجه خاص في مجال التشخيص الطبي، والأحكام التي تصدرها المركبات ذاتية القيادة.

تعدُّ التحيُّزات في نماذج تعلُّم الآلة إحدى المخاوف الأخرى المتعلقة بنماذج الصندوق الأسود، كما أن التحيُّزات الموجودة في البيانات التي يتم تدريب هذه النماذج عليها يمكِن أن تؤدي إلى نتائج غير عادلة أو عنصرية.

بالإضافة إلى ذلك، ربما يكون من الصعب تحديد المسؤولية عن القرارات التي يتخذها نموذج الصندوق الأسود؛ حيث يصعب تحميل أي شخص المسؤولية عن تلك القرارات لا سيما مع وجود الحاجة إلى الرقابة البشرية، كما هو الحال في أنظمة الأسلحة ذاتية التحكُّم

إن الافتقار إلى الشفافية في عملية اتّخاذ القرار باستخدام الذكاء الاصطناعي يُصعِّب تحديد مشكلات النموذج وحلّها، كما أن عدم معرفة الطريقة التي يتخذ بها النموذج قراراته تجعل من الصعب إجراء التحسينات والتأكُّد من أنها تعمل بطريقة صحيحة، وهناك استراتيجيات عديدة لمعالجة مشكلة الصندوق الأسود في الذكاء الاصطناعي.

تتمثَّل إحدى تلك الاستراتيجيات في استخدام تقنيات ذكاء اصطناعي قابلة للتفسير لجعل نماذج تعلُّم الآلة أكثر شفافية وأكثر قابلية للتفسير، وقد تشمل هذه التقنيات: مفسرات اللغات الطبيعية (Natural Language Explanation) أو تصوير البيانات للمساعدة في فهم عملية اتّخاذ القرار، وهناك أسلوب آخر يتمثل في استخدام نماذج تعلُّم الآلة الأكثر قابلية للتفسير مثل: أشجار القرار (Decision Trees) أو الانحدار الخطي (Linear Regression)، وربما تكون هذه النماذج أقل تعقيدًا وأسهل في الفهم، ولكنها قد لا تكون قوية أو دقيقة مثل النماذج الأكثر تعقيدًا.

تعدُّ معالجة مشكلة الصندوق الأسود في الذكاء الاصطناعي أمرًا مهمًّا لبناء الثقة في نماذج تعلُّم الآلة وضمان استخدامها بأسلوب أخلاقي وعادل.

طرائق تعزيز شفافية نماذج الذكاء الاصطناعي وقابليتها للتفسير (Methods for Enhancing the Transparency and Explainability of AI Models)

النموذج المحايد المحلي القابل للتفسير والشرح

النموذج المحايد المحلي القابل للتفسير والشرح (Local Interpretable Model-Agnostic Explanation – LIME) تم استخدامه مسبقًا في مهام معالجة اللغات الطبيعية (NLP)، وتقوم هذه التقنية بتوليد تفسيرات محلية لتنبؤات مفردة يتم إجراؤها بواسطة نموذج، وتقوم هذه التفسيرات بإنشاء نموذجًا أبسط وقابلًا للتفسير يقارب نموذج الصندوق الأسود المُعقَّد حول تنبؤ محدَّد، ثم يتم استخدام هذا النموذج البسيط لشرح كيف توصّل إلى قراره بشأن هذا التنبؤ المحدَّد.

تتمثَّل ميزة هذه التقنية في أنها توفِّر تفسيرات يمكِن للإنسان قراءتها، وبالتالي يمكِن لأصحاب المصلحة غير المتخصصين فهمها بسهولة؛ حتى فيما يتعلق بالنماذج المُعقَّدة مثل: الشبكات العصبية العميقة (Deep Neural Networks).

تفسير شابلي الإضافية

تفسير شابلي الإضافية (Shapley Additive explanations – SHAP) هي طريقة أخرى لتفسير مخرَجات نماذج تعلُّم الآلة، وتعتمد على المفهوم الخاص بقيم شابلي من نظرية الألعاب (Game Theory) وتخصِّص قيمة (أو وزنًا) لكل خاصية مساهمة في التنبؤ.

يمكِن استخدام الطريقة مع أي نموذج، كما تقدم تفسيراتٍ في شكل درجات تبيّن أهمية الخصائص؛ مما يمكِن أن يساعد في تحديد الخصائص الأكثر تأثيرًا في مخرَجات النموذج.

وهناك تقنية أخرى لتحسين قابلية تفسير الذكاء الاصطناعي مثل: أشجار القرار وقواعد القرار، وهي نماذج قابلة للتفسير يمكِن تصويرها بسهولة، حيث تقوم أشجار القرار بتقسيم فضاء الخصائص (Feature Space) بناءً على الخاصية الأكثر دلالة، وتقدِّم قواعد واضحة لاتّخاذ القرارات، وتعدُّ أشجار القرار مفيدة بشكل خاص عندما تتخذ البيانات شكل الجداول ويكون هناك عدد محدود من الخصائص.

ولكن هذه النماذج محدودة أيضًا؛ لأن قابلية تفسير شجرة القرار التي تم إنشاؤها تتناسب تناسبًا عكسيًّا مع حجم الشجرة.

على سبيل المثال، من الصعب فهم الأشجار التي تتكون من آلاف العقد ومئات المستويات.

وأخيرًا، هناك أسلوب آخر يستخدِم تقنيات مثل: وكلاء الذكاء الاصطناعي (Artificial Intelligence Agents) أو تحليل الحساسية (Sensitivity Analysis) للمساعدة في فهم كيفية تأثير تغيير المُدخَلات أو الافتراضات على مخرَجات النموذج، ويمكِن أن يكون هذا الأسلوب مفيدًا بشكل خاص في تحديد مصادر الغموض في النموذج وفي فهم حدوده.

الاستدلال القائم على القِيم في أنظمة الذكاء الاصطناعي (Value-Based Reasoning in AI Systems)

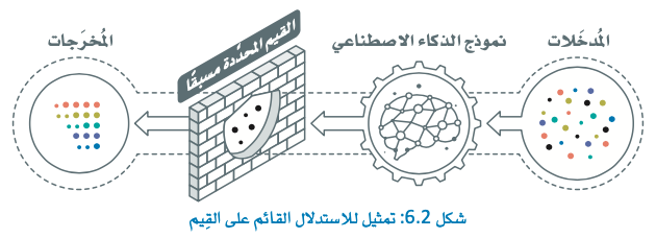

الاستدلال القائم على القِيم (Value-Based Reasoning)

الاستدلال القائم على القِيم في أنظمة الذكاء الاصطناعي يشير إلى العملية التي يستخدِمها وكلاء الذكاء الاصطناعي لاتّخاذ قرارات أو استخلاص نتائج بناءً على مجموعة محدَّدة مسبقًا من القِيم أو المبادئ أو الاعتبارات الأخلاقية.

يتمثَّل الهدف من ذلك في إنشاء أنظمة ذكاء اصطناعي أكثر اتساقًا مع القِيم والأخلاقيات البشرية؛ بحيث تتعامل هذه الأنظمة بطرائق مفيدة ومنصفة ومسؤولة.

تتضمن الخطوة الأولى في الاستدلال القائم على القِيم، فهمَ وتمثيل القِيم الأخلاقية داخل أنظمة الذكاء الاصطناعي، حيث يجب أن تكون هذه الأنظمة قادرة على تفسير وتوطين القِيم أو المبادئ التوجيهية الأخلاقية التي يقدمها منشؤها البشريون أو أصحاب المصلحة، وقد تتضمن هذه العملية التعلُّم من الأمثلة أو التغذية الراجعة البشرية أو القواعد الواضحة، وعندما تفهم أنظمة الذكاء الاصطناعي هذه القِيم بوضوح، يمكِنها أن تقوم بمواءمة أفعالها بطريقة أفضل مع المبادئ الأخلاقية المنشودة.

يركِّز الجانب الثاني من جوانب الاستدلال القائم على القِيم على تقييم القرارات أو الأفعال بناءً على القِيم التي وطنّت (Internalized Values)، ويجب أن تقوم أنظمة الذكاء الاصطناعي بتقييم النتائج المحتملة للقرارات أو الإجراءات المختلفة بالنظر في عواقب كل خيار ومخاطره وفوائده، كما يجب أن تأخذ عملية التقييم هذه في الاعتبار القِيم الأساسية التي تم تصميم نظام الذكاء الاصطناعي لدعمها؛ مما يضمن أن يتخذ النظام خيارات مستنيرة ومتوافقة مع القِيم.

وأخيرًا، يتطلَّب الاستدلال القائم على القِيم من أنظمة الذكاء الاصطناعي اتّخاذ قرارات تتماشى مع القِيم الراسخة، فبعد تقييم الخيارات المختلفة ونتائجها المحتملة، يجب على نظام الذكاء الاصطناعي أن ينتقي القرار أو الإجراء الذي يمثِّل المبادئ والأهداف الأخلاقية التي صُمِّم لاتباعها، فمن خلال اتّخاذ قرارات متوافقة مع القِيم، يمكِن لوكلاء الذكاء الاصطناعي (AI Agents) التصرُّف بطرائق تتفق مع المبادئ التوجيهية الأخلاقية التي وضعها منشؤها؛ مما يعزِّز السلوك المسؤول والمفيد.

على سبيل المثال: يتم استخدام أنظمة الذكاء الاصطناعي في الرعاية الصحية للمساعدة في اتّخاذ قرارات التشخيص والعلاج، حيث يجب أن تكون هذه الأنظمة قادرة على التفكير في الآثار الأخلاقية المترتبة على العلاجات المختلفة مثل: الآثار المحتملة أو التأثير على جودة الحياة ومن ثَمّ تتخذ قرارات تعطي الأولوية لسلامة المريض، ومن الأمثلة الأخرى: أنظمة الذكاء الاصطناعي المُستخدَمة في التمويل للمساعدة في اتّخاذ قرارات الاستثمار، حيث يجب أن تكون هذه الأنظمة قادرة على أن تفكر في الآثار الأخلاقية المترتبة على الاستثمارات المختلفة، كالتأثير على البيئة أو على الرعاية الاجتماعية، وبالتالي تتخذ القرارات التي تتماشى مع قِيم المستثمر.

يجب أن ندرك أن المسؤولية لا تقع بأكملها على عاتق نظام الذكاء الاصطناعي؛ بل إنها مسؤولية مشتركة بين الذكاء الاصطناعي والخبراء البشريين، فنظام الذكاء الاصطناعي يساعد في اتّخاذ القرار بأن يُلخِّص الحالة ويقدِّم الخيارات أو العروض للمُستخدِم الخبير الذي يتخذ القرار النهائي؛ مما يؤكد أن الخبير البشري هو المتحكم والمسؤول عن النتيجة النهائية، في ظل الاستفادة من الأفكار والتحليلات التي يوفرها نظام الذكاء الاصطناعي.

بإمكانك مراجعة محتوى موضوع “مقدمة في أخلاقيات الذكاء الاصطناعي” بدايةً من عنوان “الشفافية وقابلية التفسير في الذكاء الاصطناعي ومشكلة الصندوق الأسود” وحتى نهاية هذا القسم، من خلال الرابط التالي:

الذكاء الاصطناعي وتأثيره على البيئة (AI and Environmental Impact)

إن تأثير الذكاء الاصطناعي على البيئة وعلى علاقتنا بها معقَّد ومتعدِّد الأوجه.

مقدمة في أخلاقيات الذكاء الاصطناعي

- فوائده المحتملة

يمكِن للذكاء الاصطناعي أن يساعد في فهم التحديات البيئية والتعامل معها بشكل أفضل مثل: تغيُّر المناخ، والتلوث، وفقدان التنوع البيولوجي، ويمكِنه أن يساعد في تحليل كميات هائلة من البيانات والتنبؤ بتأثير الأنشطة البشرية المختلفة على البيئة، ويمكِنه كذلك أن يساعد في تصميم أنظمة أكثر كفاءة واستدامة مثل: أنظمة شبكات الطاقة، والزراعة، والنقل، والمباني.

- أخطاره أو أضراره المُحتملة

هناك مخاوف من تأثير الذكاء الاصطناعي نفسه على البيئة؛ إذ يتطلَّب تطوير أنظمة الذكاء الاصطناعي واستخداماتها قدرًا كبيرًا من الطاقة والموارد؛ مما قد يسهِّم في انبعاث غازات تُفاقِم من مشكلة الاحتباس الحراري وغيرها من الآثار البيئية.

على سبيل المثال، قد يتطلَّب تدريب نموذج واحد للذكاء الاصطناعي قدرًا من الطاقة يعادل ما تستهلكه العديد من السيارات طوال حياتها.

بالإضافة إلى ذلك، يمكِن أن يساهم إنتاج المُكوِّنات الإلكترونية المُستخدَمة في تصنيع أنظمة الذكاء الاصطناعي في تلوث البيئة مثل: استخدام المواد الكيميائية السامة وتوليد النفايات الإلكترونية.

علاوة على ذلك، يمكِن أن يغير الذكاء الاصطناعي علاقتنا بالبيئة بطرائق ليست إيجابية دائمًا، فقد يؤدي استخدام الذكاء الاصطناعي في الزراعة إلى ممارسات زراعية مكثَّفة ومركِّزة على الصناعة؛ مما يؤثر سلبًا على صحة التربة والتنوع البيولوجي.

بالمثل، ربما يؤدي استخدام الذكاء الاصطناعي في النقل إلى زيادة الاعتماد على السيارات وأساليب النقل الأخرى؛ مما يسهِّم في تلوث الهواء وتدمير البيئات الطبيعية التي تسكنها الكائنات الحية.

الخاتمة

بوجه عام، يعتمد تأثير الذكاء الاصطناعي على البيئة وعلاقتنا بها على كيفية تطوير أنظمة الذكاء الاصطناعي واستخدامها، ومن المهم النظر في التأثيرات البيئية المحتملة للذكاء الاصطناعي وتطوير أنظمته واستخدامها بطرائق تعطي الأولوية للاستدامة والكفاءة وسلامة كوكب الأرض.

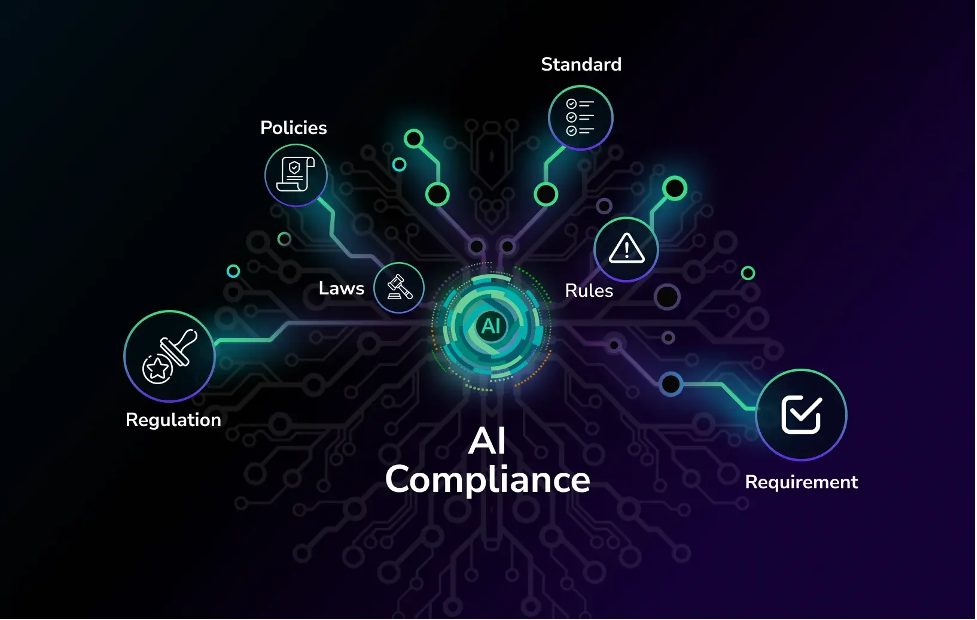

الأُطر التنظيمية ومعايير الصناعة (Regulatory Frameworks and Industry Standards)

تلعب الأُطر التنظيمية ومعايير الصناعة دورًا مهمًّا في تعزيز تطبيقات الذكاء الاصطناعي الأخلاقية، فبإمكان التنظيمات المُساعِدة أن تضمن تحمُّل المنظمات التي تقوم بتطوير واستخدام أنظمة الذكاء الاصطناعي المسؤولية عن أفعالها عن طريق تحديد توقُّعات وعواقب واضحة لعدم الامتثال، وبإمكان التنظيمات والمعايير أن تُحفز المنظمات على إعطاء الأولوية للاعتبارات الأخلاقية عند تطوير واستخدام أنظمة الذكاء الاصطناعي.

مقدمة في أخلاقيات الذكاء الاصطناعي

- الشفافية

يمكِن أن تعزِّز التنظيمات والمعايير الشفافية في أنظمة الذكاء الاصطناعي بمطالبة المؤسسات بالكشف عن كيفية عمل أنظمتها وعن البيانات التي تستخدمها، ويمكِن أن يساعد ذلك في بِناء الثقة مع أصحاب المصلحة وتقليل المخاوف من التحيُّزات المحتملة أو التمييز المحتمل في أنظمة الذكاء الاصطناعي.

- تقييم المخاطر

يمكِن تقليل مخاطر العواقب غير المقصودة أو النتائج السلبية الناتجة عن استخدام الذكاء الاصطناعي بوضع التنظيمات والمعايير المناسبة، وذلك بمطالبة المنظمات بإجراء تقييمات للمخاطر، وهذا يعني تحديد المخاطر والأخطار المحتملة وتنفيذ ضمانات مناسبة، مما يمكِّن التنظيمات والمعايير من المساعدة في تقليل الأضرار المحتملة على الأفراد والمجتمع.

- تطوير ونشر أُطر عمل واضحة للذكاء الاصطناعي

يمكِن أن تشجِّع التنظيمات والمعايير الابتكار بتوفير إطار عمل واضح لتطوير أنظمة الذكاء الاصطناعي واستخدامها؛ إذ أن استخدام التنظيمات والمعايير لتأسيس فرص متكافئة وتقديم التوجيه بخصوص الاعتبارات الأخلاقية يمكِن أن يساعد المنظمات على تطوير أنظمة الذكاء الاصطناعي ونشرها بطرائق تتفق مع القيم الأخلاقية والاجتماعية.

تلعب الأُطر التنظيمية ومعايير الصناعة دورًا مهمًّا في تعزيز تطبيقات الذكاء الاصطناعي الأخلاقية، وذلك بتوفير إرشادات وحوافز واضحة للمؤسسات حتى تعطي الأولوية للاعتبارات الأخلاقية والتنظيمات والمعايير؛ مما يضمن تطوير أنظمة الذكاء الاصطناعي واستخدامها بطرائق تتماشى مع القِيم الاجتماعية والأخلاقية.

التنمية المستدامة للذكاء الاصطناعي في المملكة العربية السعودية (Sustainable AI Development in the Kingdom of Saudi Arabia)

من المتوقَّع أن تصبح تقنيات الذكاء الاصطناعي وأنظمته أحد العوامل الرئيسة التي تؤدي إلى إحداث خلل في القطاعات المالية في العديد من البلدان، وقد تؤثر بشكل كبير على سوق العمل، ومن المتوقَّع في السنوات القادمة أن يصبح حوالي 70% من الأعمال الروتينية التي يقوم بها العمال مؤتمتة بالكامل.

كما أنه من المتوقَّع أن تخلق صناعة الذكاء الاصطناعي 97 مليون وظيفة جديدة وتضيف 16 تريليون دولار أمريكي إلى الناتج المحلي الإجمالي العَالَمي.

لقد طوَّرت الهيئة السعودية للبيانات والذكاء الاصطناعي (Saudi Data and Artificial Intelligence Authority – SDAIA) أهدافًا استراتيجية للمملكة لاستخدام تقنيات الذكاء الاصطناعي المُستدامة في تنمية المملكة، وستكون المملكة العربية السعودية مركزًا عالميًا للبيانات والذكاء الاصطناعي، كما أن المملكة استضافت أول قمة عالمية له، حيث يمكِن للقادة والمبتكرين مناقشة مستقبل الذكاء الاصطناعي وتشكيله لصالح المجتمع.

أما الهدف الآخر فيتمثل في تحويل القوى العاملة في المملكة من خلال تطوير البيانات المحلية ودعم المواهب في الذكاء الاصطناعي.

وبما أن الذكاء الاصطناعي يقوم بتحويل أسواق العمل عالميًا، فإن معظم القطاعات تحتاج إلى تكييف البيانات والذكاء الاصطناعي ودمجها في التعليم والتدريب المهني والمعرِفة العامة، وبذلك يمكِن أن تكتسب المملكة العربية السعودية ميزة تنافسية من حيث التوظيف والإنتاجية والابتكار.

أما الهدف النهائي فيتمثَّل في جذب الشركات والمستثمرين عن طريق أُطر عمل وحوافز تنظيمية مرنة ومستقرة، حيث ستركز الأنظمة على تطوير سياسات ومعايير للذكاء الاصطناعي، بما فيها استخدامه بشكل أخلاقي.

وسيعمل إطار العمل على تعزيز التطوير الأخلاقي لأبحاث وحلول الذكاء الاصطناعي ودعمه في ظل توفير إرشادات ومعايير لحماية البيانات والخصوصية؛ مما سيُوفِّر الاستقرار والتوجيه لأصحاب المصلحة العاملين في المملكة.

الإرشادات العالمية لأخلاقيات الذكاء الاصطناعي (International AI Ethics Guidelines)

كما هو موضَّح في الجدول التالي، طوَّرت منظمة اليونسكو (UNESCO) وثيقة إرشادية توضِّح بالتفصيل القِيم والمبادئ التي يجب الالتزام بها عند تطوير أنظمة وتقنيات الذكاء الاصطناعي الجديدة.

بإمكانك مراجعة محتوى موضوع “مقدمة في أخلاقيات الذكاء الاصطناعي” بدايةً من عنوان “الذكاء الاصطناعي وتأثيره على البيئة” وحتى نهاية الموضوع، من خلال الرابط التالي:

إلى هنا يكون قد انتهى موضوع “مقدمة في أخلاقيات الذكاء الاصطناعي”، لا تنسوا مراجعة نواتج التعلُّم أعلى المقال، وانتظرونا في الموضوع القادم!